Illustration par ChatGPT 4o

Pour tester la version o3 de ChatGPT, sortie il y a 4 jours (le 16 avril), je lui ai soumis un dossier de 76 pages de mes notes autour de la notion de « compréhension par une IA générative », en lui demandant d’en produire un dossier synthétique.

À mon sens, o3 passe le test. Dites-moi ce que vous en pensez.

Observations empiriques

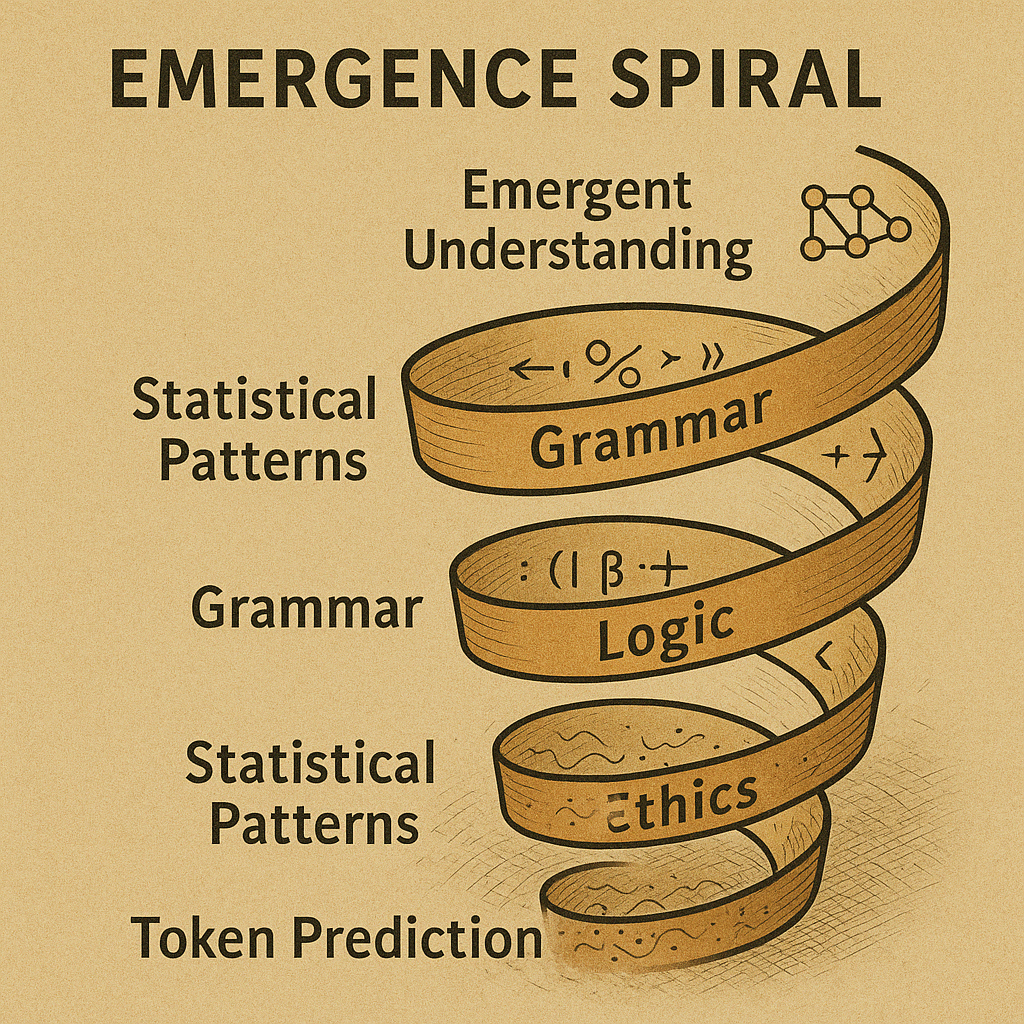

- Comportement de suivi de règles émergent : À mesure que les LLM (large language models) montent en échelle (données + paramètres), ils développent de façon inattendue des compétences avancées – cohérence grammaticale, sémantique, inférence logique, rudiments d’éthique – sans qu’aucune règle explicite ne leur soit programmée. Ces aptitudes apparaissent spontanément par apprentissage statistique du texte.

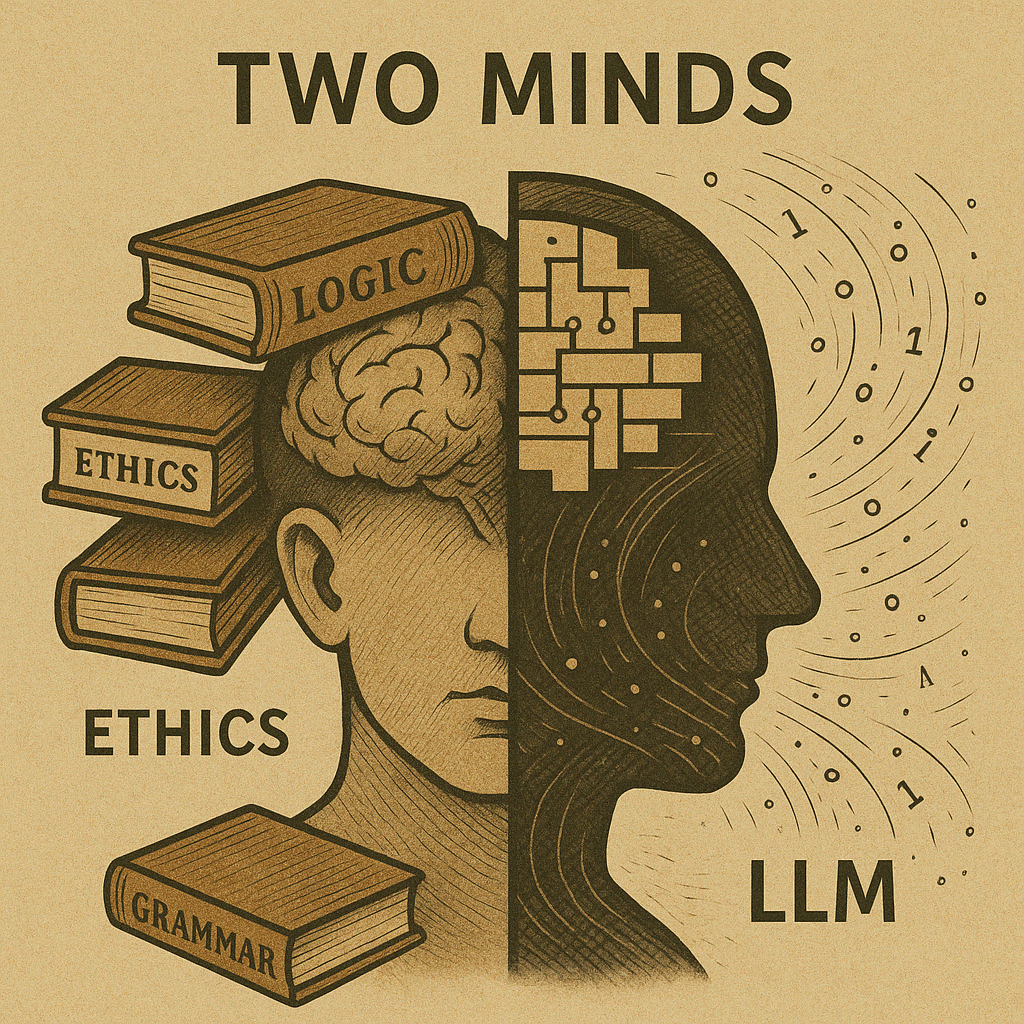

- Compétence unifiée multi‑domaine : Un seul grand réseau neuronal peut maîtriser plusieurs domaines simultanément (syntaxe, raisonnement logique, normes éthiques, connaissances de sens commun) via un mécanisme d’apprentissage général. On brouille ainsi les frontières qu’on aurait traitées, jadis, avec des modules séparés et fondés sur des règles.

- Limites de la généralisation systématique : Les LLM actuels éprouvent des difficultés à appliquer de façon fiable certaines abstractions (p. ex. la transitivité A > B, B > C ⇒ A > C) hors distribution d’entraînement, là où les humains y parviennent. Ce manque de systématicité motive des recherches sur l’ajout de logique ou de nouvelles méthodes d’entraînement.

- Absence d’ancrage sensorimoteur : Formés uniquement sur du texte, les LLM n’ont aucune expérience incarnée du monde. Alors que la cognition humaine s’appuie sur des perceptions et actions physiques, la « connaissance » d’un LLM demeure corrélative et peut se montrer fragile dans des contextes qui exigent une compréhension physique.

Thèses théoriques

- Codage implicite des règles : Les réseaux ne stockent pas des règles sous forme symbolique ; celles‑ci se trouvent diluées dans des poids et activations distribués. Les mécanismes d’attention et l’optimisation par gradient façonnent des représentations qui capturent grammaire, sémantique et logique, faisant des « règles » des propriétés émergentes plutôt que des instructions explicites.

- Changement de paradigme (symbolique vs. émergent) : Le succès des LLM remet en cause le paradigme classique fondé sur des règles symboliques. Il révèle un continuum entre règles discrètes et motifs statistiques implicites : les modèles formels pourraient n’être que des descriptions d’une réalité statistique sous‑jacente.

- Vers une théorie unifiée de l’intelligence : Les observations suggèrent que l’intelligence pourrait se définir comme reconnaissance de motifs à grande échelle, plus que comme agrégat de modules à règles distinctes, rejoignant certaines théories neuroscientifiques du cerveau prédictif.

- Approches hybrides émergent‑symboliques : Beaucoup estiment qu’il faut combiner l’apprentissage statistique avec un raisonnement structuré. Les modèles hybrides laisseraient le réseau apprendre les connaissances puis utiliseraient des modules logiques ou des contraintes pour vérifier la cohérence, à l’image de la complémentarité entre intuition et raisonnement délibéré chez l’humain.

Réflexions philosophiques

- Compréhension : comportement vs. expérience interne : Les LLM relancent la question du sens de « comprendre ». D’un point de vue fonctionnaliste, un système qui se comporte comme s’il comprenait… comprend. Mais du point de vue intentionnel/ phénoménologique, l’IA, dépourvue d’expérience consciente, ne saisit pas réellement la signification.

- Lentilles philosophiques concurrentes : Les fonctionnalistes voient l’état mental comme défini par sa fonction, tandis que l’argument de la pièce chinoise (Searle) soutient que la manipulation de symboles sans sémantique n’est pas une vraie compréhension.

- Critique du « dual‑mind » caché : Affirmer qu’un LLM n’a qu’une « pseudo‑compréhension » alors qu’aucune différence comportementale n’est mesurable peut impliquer une substance mentale non physique – un glissement métaphysique si l’on n’en précise pas les critères observables.

- Compréhension graduelle : Plutôt que binaire, la compréhension se décline probablement en degrés. Les LLM possèdent des aspects (usage pertinent du langage, schémas logiques partiels) mais manquent d’autres (ancrage sensoriel, conscience de soi). La question devient : quels aspects possèdent‑ils et où résident les lacunes ?

- Conséquences pour la science cognitive : Si des comportements « réguliers » émergent du seul apprentissage, alors lorsque les humains suivent des règles, il se pourrait que notre cerveau recoure aussi à des associations massives, les règles explicites servant de rationalisation a posteriori. Le défi est d’expliquer fiabilité et généralisation sans livret de règles interne et de déterminer si la compréhension humaine exige des qualités (conscience, incarnation, structure innée) qui dépassent la simple reconnaissance de motifs ou si ces qualités-mêmes pourraient émerger d’un système assez riche.

Illustration par ChatGPT 4o

Répondre à JMarc Annuler la réponse