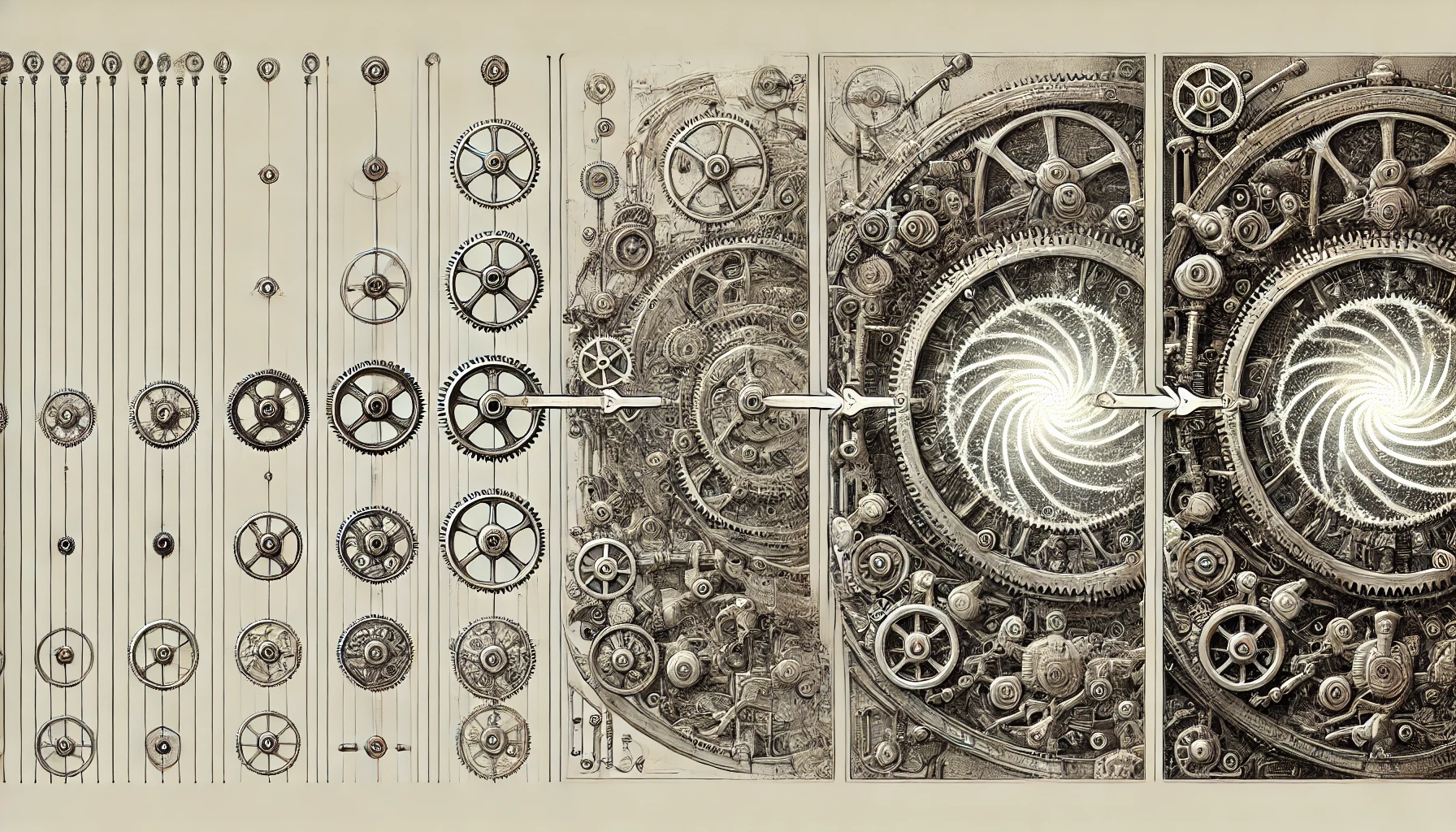

Illustration par DALL·E

Le gain en taille

Une deuxième source de notre impréparation à une intelligence artificielle supérieure à la nôtre est que la manière même dont le dépassement s’est produit a causé la surprise, étant presque entièrement due à un simple gain en taille – l’élément supplémentaire étant le « transformer ».

La voie vers la synthèse de l’intelligence humaine qui s’est avérée être la bonne était contre-intuitive : le premier prototype d’un réseau neuronal artificiel, le perceptron, n’était encore qu’un dispositif modérément prometteur. Ce type élémentaire de modèle connexionniste fut sévèrement critiqué par deux vedettes de la recherche en intelligence artificielle : Marvin Minsky et Seymour Papert, qui consacrèrent un livre à démontrer que les approches connexionnistes étaient sans avenir. Leur opus Perceptrons avait été publié en 1969 mais, en 1988, les auteurs ne s’étaient toujours pas repentis de leur condamnation. Après avoir suggéré dans le nouveau prologue d’une réimpression de leur livre que le connexionnisme n’était probablement rien de plus qu’une mode : « L’intérêt nouveau reflète-t-il un tournant culturel vers le holisme ? », ils ajoutaient : « Les merveilleux pouvoirs du cerveau n’émergent pas d’un réseau connexionniste unique et uniformément structuré, mais d’arrangements hautement évolués de réseaux plus petits et spécialisés, interconnectés de manière très spécifique », une affirmation qui reste vraie globalement mais qui, pour ce qui est de la capacité à générer des phrases porteuses de sens, fut discréditée par le succès des Grands Modèles de Langage (Large Language Model : LLM).

Il était en effet stupéfiant de constater que toutes les propriétés remarquables de l’intellect humain émergeaient l’une après l’autre d’un simple gain en taille des réseaux neuronaux artificiels construits pour tenter de simuler le psychisme humain : gain en taille de leur architecture en termes de nombre de neurones artificiels, gain en taille de la quantité de données ingurgitées au cours de leur phase de formation : le « pré-entraînement ».

C’est laborieusement que nous avons élaboré au fil des siècles la linguistique et ses composantes apparemment distinctes, telles que la syntaxe, la sémantique, la pragmatique, la logique, jusqu’à la prise de décision, en construisant des modèles mathématiques du comportement que nous observions, comme si chacun de ces comportements résultait de l’application d’un ensemble spécifique de règles. Mais lorsque nous avons fait appel à ces modèles sophistiqués dans nos tentatives de développement de projets d’intelligence artificielle, nous sommes allés de déception en déception : chaque fois que nous imaginions l’objectif à portée de la main, nous nous apercevions que de nouvelles règles manquaient encore et que l’appareil déjà hyper-complexe devait être remis sur la chaine de montage.

L’explication, que nous avons maintenant saisie avec le recul de l’expérience LLM, est que l’application d’une myriade de règles n’est tout simplement pas la façon dont notre cerveau opère avec le langage. Il s’est confirmé que les compétences linguistiques de ces IA s’amélioraient pour nulle autre raison qu’un corpus de données d’apprentissage plus volumineux et plus étroitement connecté, de nouvelles capacités surprenantes apparaissant par auto-organisation dans le cadre d’un processus à chaque fois soudain d’émergence. Malheureusement, ces phénomènes émergents imprévisibles demeurent opaques à l’esprit humain en raison de certaines caractéristiques des systèmes gagnant en taille et en complexité, comme la faible prévisibilité de processus non-linéaires, la complexité de frontières fractales entre les bassins d’attraction des espaces de phase dans les systèmes dynamiques, et les chemins rapidement divergents dans la dynamique de ces systèmes complexes, même s’ils étaient quasi identiques dans leurs conditions initiales.

Illustration par DALL·E

Laisser un commentaire