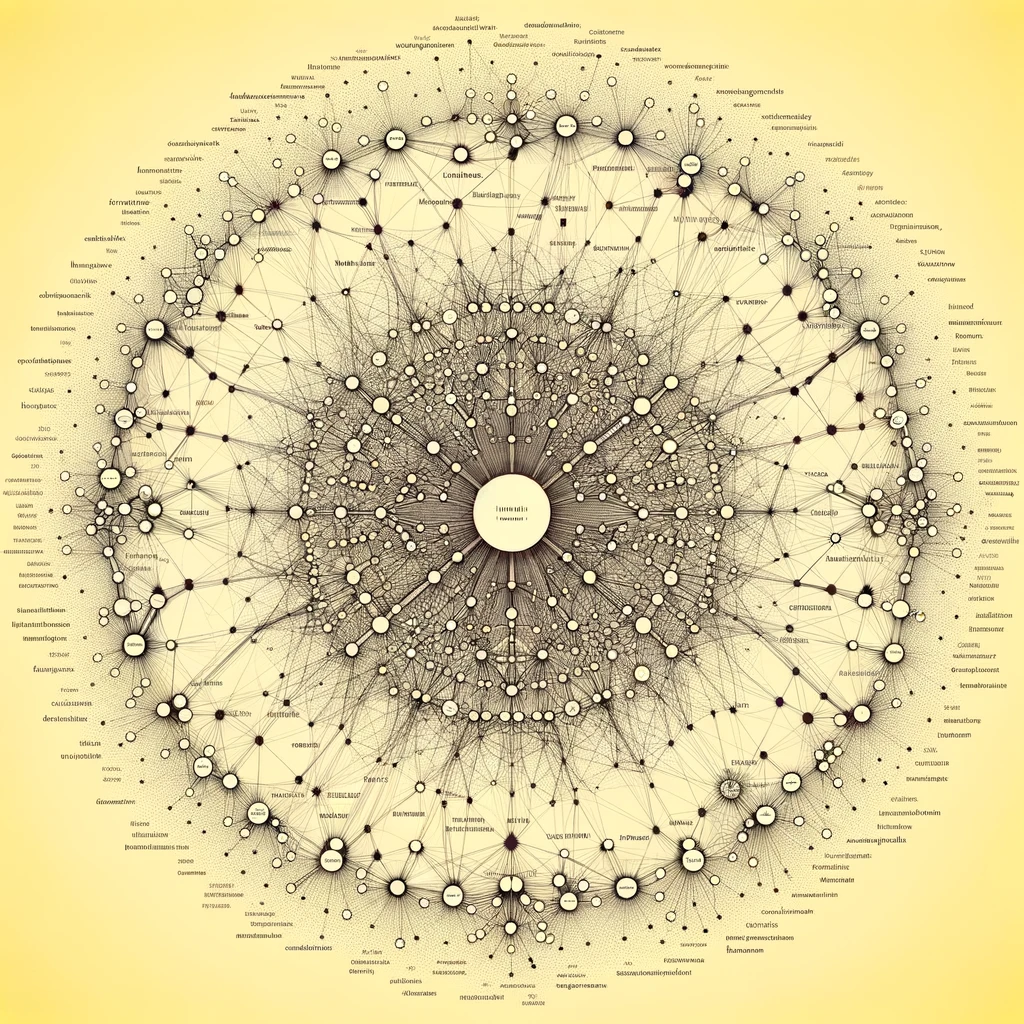

Illustration par DALL·E (+PJ)

Je suis très heureux d’entendre enfin un son de cloche positif quant à l’IA quand le discours ambient vise soit à déformer soit même à nier les progrès faits dans le domaine.

Je suis chercheur en linguistique informatique depuis près de 30 ans. J’ai fait une maitrise d’informatique à l’Institut de Programmation de Paris VI dans les années 80 avant de faire une thèse en linguistique à l’Université de Montréal. J’ai fait la majorité de ma carrière autour des méthodes symboliques au sein de l’équipe ParSem à XRCE (le centre européen de recherche de Xerox à Grenoble). J’y ai développé à la suite de ma thèse un moteur d’analyse syntaxique : XIP qui dans les années 2000 permettait d’extraire des dépendances dans un texte à la vitesse de 3000 mots/s. En 2016 nous avons même gagné une compétition à SemEval pour l’extraction des sentiments dans un corpus de critiques de restaurant.

Puis en 2017 est sorti transformer (l’article « Attention is all you need ») et à partir de là tout s’est emballé…

Pour les esprits chagrins qui nient l’existence de ces progrès, je réponds la chose suivante: JE NE PENSAIS PAS VOIR DÉBARQUER UNE TELLE TECHNOLOGIE DE MON VIVANT.

Suis-je amer ? Certainement pas, j’ai la chance de vivre tout ce dont j’ai rêvé quand j’ai commencé à travailler dans le domaine. Traduction Automatique, Analyse de texte, Génération de texte et de code, Compréhension du texte, j’en passe et des meilleurs.

Alors pourquoi ont-ils réussi là où l’équipe dans laquelle j’ai travaillé pendant 20 ans a échoué ?

Il n’y a certainement pas de réponse simple, mais je vais tenter d’apporter ma pierre personnelle, qui vaut ce qu’elle vaut. Que les vrais spécialistes pardonnent à quelqu’un qui a erré sur les chemins du symbolique…

La linguistique traditionnelle (j’y inclus aussi les méthodes à noyaux) a divisé la langue en une multitude de champs différents : lexicologie, syntaxe, sémantique, analyse du discours sans jamais réussir à jeter des ponts entre ces domaines.

Nous faisions de la syntaxe en mêlant un peu de sémantique dans notre groupe, mais nous nous heurtions sans cesse à un plafond de verre, car le sens commun nous échappait. Nous n’arrivions pas à injecter suffisamment de connaissances du monde dans nos approches et le moindre antécédent qu’il soit anaphorique ou pire cataphorique faisait déraper nos modèles.

Malgré tous nos efforts, notre travail restait laborieux et maladroit… Nous arrivions à quelques résultats, certes, mais au prix d’un labeur de bénédictin.

Les Grands Modèles de Langue unifient l’ensemble de ces axes. Car lorsque un GML fonctionne, il dispose d’une représentation unifiée de la sémantique (les plongements ou embeddings) que l’utilisation de l’attention permet de mettre en regard les uns avec les autres.

On entend souvent des critiques affirmer avec une certaine morgue que ces modèles ne font que compléter le mot suivant. C’est idiot… Ce que ces modèles font c’est apprendre sur des contextes de plusieurs milliers de tokens à deviner un mot masqué. D’une certaine manière, ils sont entrainés à résoudre des milliards d’exercices à trous. Et ils apprennent dès lors, des milliards de motifs sémantiques extrêmement fins, je dis sémantique, parce que les plongements ne sont pas vraiment liés à une langue donnée, mais bel et bien à des concepts sémantiques. En ingérant toute la connaissance du monde, ils finissent par construire un filet qui lie entre elles toutes les expériences présentes et passées de notre humanité.

En cela, ils sont une parfaite distillation de nos civilisations.

Aujourd’hui, je crois qu’il faut absolument démultiplier nos efforts en recherche dans tous les domaines et dans toutes les langues, pour fournir toujours plus de données à ces modèles, parce que nombre de nos problèmes actuels, dans le monde de l’énergie ou de la médecine, trouveront peut-être leur solution dans le croisement de données scientifiques disparates que nos cerveaux humains limités sont incapables d’établir. Il existe peut-être un texte en sanscrit qui décrit une méthode pour soigner certaines maladies avec certaines plantes. Aujourd’hui, il devient possible pour n’importe qui d’y avoir accès.

Il s’est publié près de 3 millions d’articles scientifiques l’an dernier, seule la machine peut les digérer tous.

Illustration par DALL·E (+PJ)

Laisser un commentaire