Une dépêche de l’agence Reuters a peut-être révélé les véritables enjeux de la révolution de palais chez OpenAI, celle qui a vu son PD-G Sam Altman, être renversé avant d’être réinstitué par une fronde quasi unanime des employés.

Voici ce qu’affirmait la dépêche :

Selon certaines sources, des chercheurs d’OpenAI ont prévenu le conseil d’administration de la percée de l’IA avant l’éviction du P-DG,

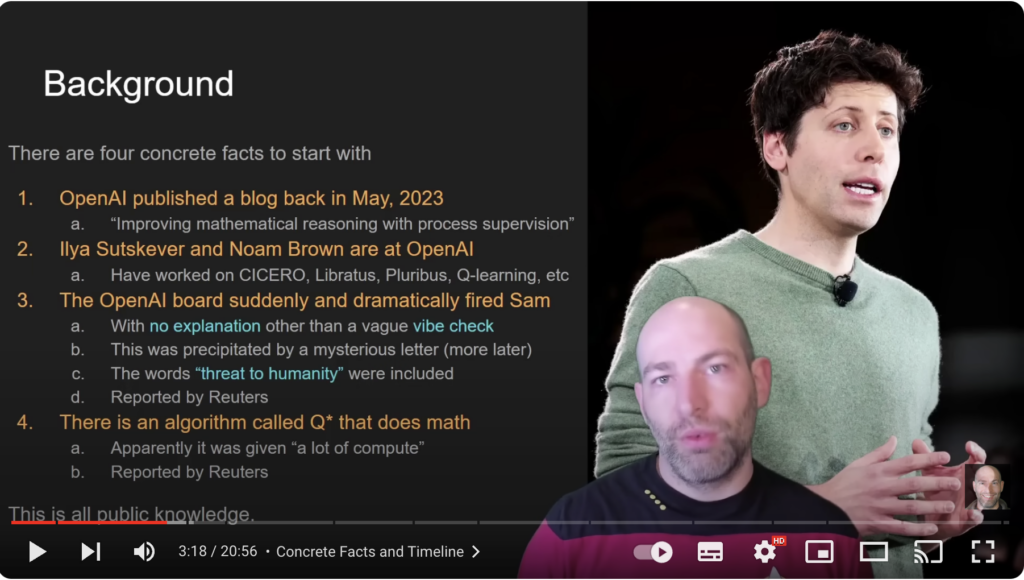

Par Anna Tong, Jeffrey Dastin et Krystal Hu22 novembre (Reuters) – Avant les quatre jours d’exil du P-DG d’OpenAI, Sam Altman, plusieurs chercheurs de l’entreprise ont écrit une lettre au conseil d’administration pour l’avertir d’une puissante découverte en matière d’intelligence artificielle qui, selon eux, pourrait menacer l’humanité, ont déclaré à Reuters deux personnes au fait de l’affaire.

La lettre et l’algorithme d’intelligence artificielle, qui n’avaient pas été signalés auparavant, ont été des éléments clés avant l’éviction par le conseil d’administration de M. Altman, la tête d’affiche de l’intelligence artificielle générative, ont déclaré les deux sources. Avant son retour triomphal mardi, plus de 700 employés avaient menacé de démissionner et de rejoindre Microsoft en solidarité avec leur chef licencié.

Les sources ont cité la lettre comme l’un des facteurs d’une longue liste de griefs formulés par le conseil d’administration qui ont conduit au licenciement de M. Altman, parmi lesquels des préoccupations concernant la commercialisation des avancées avant d’en comprendre les conséquences. Reuters n’a pas été en mesure d’examiner une copie de la lettre. Le personnel qui a rédigé la lettre n’a pas répondu aux demandes de commentaires.

Après avoir été contactée par Reuters, la société OpenAI, qui s’est refusée à tout commentaire, a reconnu dans un message interne adressé aux membres du personnel l’existence d’un projet appelé Q* et d’une lettre adressée au conseil d’administration avant les événements du week-end, a déclaré l’une des personnes concernées. Un porte-parole d’OpenAI a déclaré que le message, envoyé par Mira Murati, cadre de longue date, alertait le personnel sur certains articles de presse sans en commenter l’exactitude.

Certaines personnes chez OpenAI pensent que Q* (prononcé Q-Star) pourrait être une percée dans la recherche de ce que l’on appelle l’intelligence artificielle généraliste (AIG), a déclaré l’une d’entre elles à Reuters. OpenAI définit l’AIG comme des systèmes autonomes qui surpassent les humains dans la plupart des tâches à valeur économique.

Avec de vastes ressources informatiques, le nouveau modèle a pu résoudre certains problèmes mathématiques a déclaré cette personne sous couvert d’anonymat car elle n’était pas autorisée à parler au nom de l’entreprise. Bien qu’il n’atteigne que le niveau des élèves de l’école primaire, le fait de réussir de tels tests a rendu les chercheurs très optimistes quant au succès futur de Q*, a déclaré la source.

Reuters n’a pas pu vérifier de manière indépendante les capacités de Q* annoncées par les chercheurs.

Les chercheurs considèrent les mathématiques comme l’une des pierres angulaires du développement de l’IA générative. Actuellement, l’IA générative est efficace pour l’écriture et la traduction des langues en prédisant statistiquement le mot suivant, et les réponses à une même question peuvent varier considérablement. Mais conquérir la capacité de faire des mathématiques – où il n’y a qu’une seule bonne réponse – implique que l’IA aurait des capacités de raisonnement plus grandes, proches de l’intelligence humaine. Selon les chercheurs en IA, cela pourrait s’appliquer à de nouvelles recherches scientifiques, par exemple.

Contrairement à une calculatrice qui ne peut résoudre qu’un nombre limité d’opérations, l’IA peut généraliser, apprendre et comprendre.

Dans leur lettre au conseil d’administration, les chercheurs ont souligné les prouesses de l’IA et les dangers potentiels, ont indiqué les sources, sans préciser les problèmes de sécurité exacts mentionnés dans la lettre. Les informaticiens débattent depuis longtemps du danger que représentent les machines hautement intelligentes, par exemple si elles peuvent décider que la destruction de l’humanité est dans leur intérêt.

Les chercheurs ont également signalé les travaux d’une équipe de « scientifiques de l’IA », dont l’existence a été confirmée par plusieurs sources. Ce groupe, issu de la fusion des équipes « Code Gen » et « Math Gen », étudiait les moyens d’optimiser les modèles d’IA existants afin d’améliorer leur raisonnement et, à terme, d’effectuer des travaux scientifiques, a indiqué l’une des personnes interrogées.

M. Altman a dirigé les efforts visant à faire de ChatGPT l’une des applications logicielles à la croissance la plus rapide de l’histoire et a attiré les investissements – et les ressources informatiques – nécessaires de la part de Microsoft pour se rapprocher de l’IAG.

Outre l’annonce d’une série de nouveaux outils lors d’une démonstration ce mois-ci, M. Altman a laissé entendre la semaine dernière, lors d’un sommet de dirigeants mondiaux à San Francisco, qu’il pensait que des avancées majeures étaient en vue. « Quatre fois dans l’histoire d’OpenAI, la dernière fois au cours des deux dernières semaines, j’ai eu l’occasion d’être présent lorsque nous repoussons le voile de l’ignorance et la frontière de la découverte, et c’est l’honneur professionnel d’une vie », a-t-il déclaré lors du sommet de l’Organisation de coopération économique Asie-Pacifique (APEC).

Un jour plus tard, le conseil d’administration licenciait M. Altman.

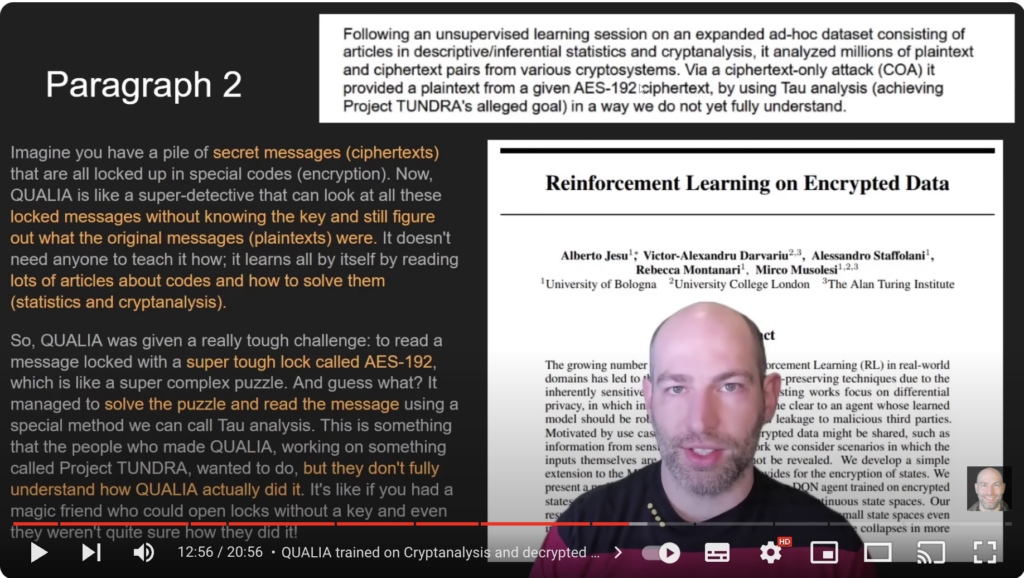

Tout cela paraît cependant assez innocent, à ceci près que, traduit en bon français, cela signifie, par exemple, la capacité pour les nouvelles IA de décrypter en un temps limité un texte jusque-là indéchiffrable, au sens où le décryptage aurait pris un nombre quasi-infini de temps-machine.

D’excellentes explications ici :

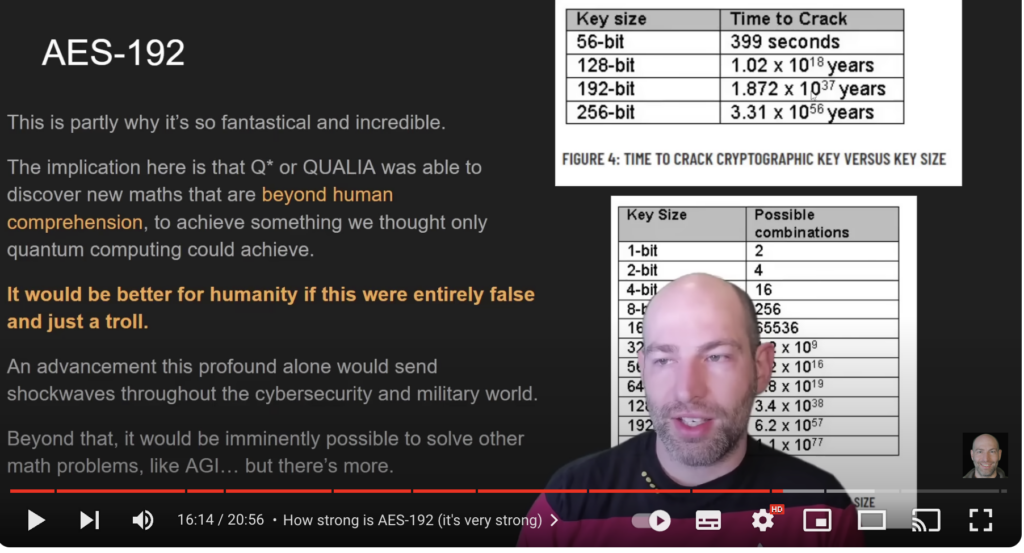

Le temps nécessaire pour déchiffrer un bit AES-192 est 1,8 fois 10 37 années. Ce qui représente une très longue période de temps. Si un GPT ou un autre type de réseau neuronal profond est capable de le craquer en un temps apparemment insignifiant, cela bouleverse tout ce que nous savons de la cryptographie. L’implication ici est que Q* ou QUALIA a été capable de découvrir de nouvelles mathématiques qui dépassent l’entendement humain pour réaliser quelque chose que nous pensions que seule l’informatique quantique pouvait réaliser.

Il serait préférable pour l’humanité que cela soit entièrement faux et qu’il s’agisse d’un troll. Je n’exagère pas.

Une avancée aussi profonde provoquerait à elle seule une onde de choc dans le monde de la cybersécurité et de l’armée. En outre, il serait tout à fait possible de résoudre d’autres problèmes mathématiques tels que l’Intelligence Artificielle Généraliste.

Implications :

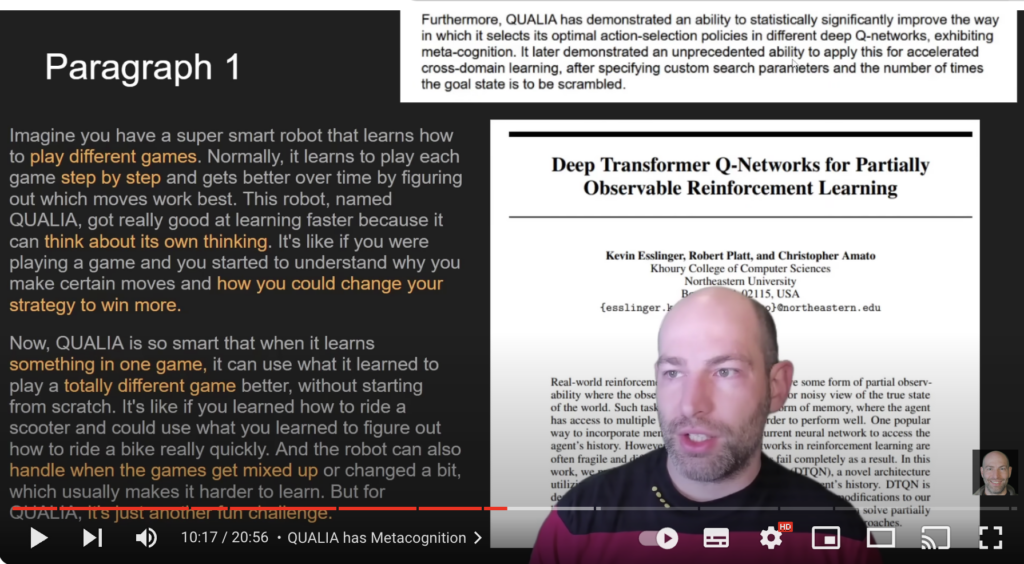

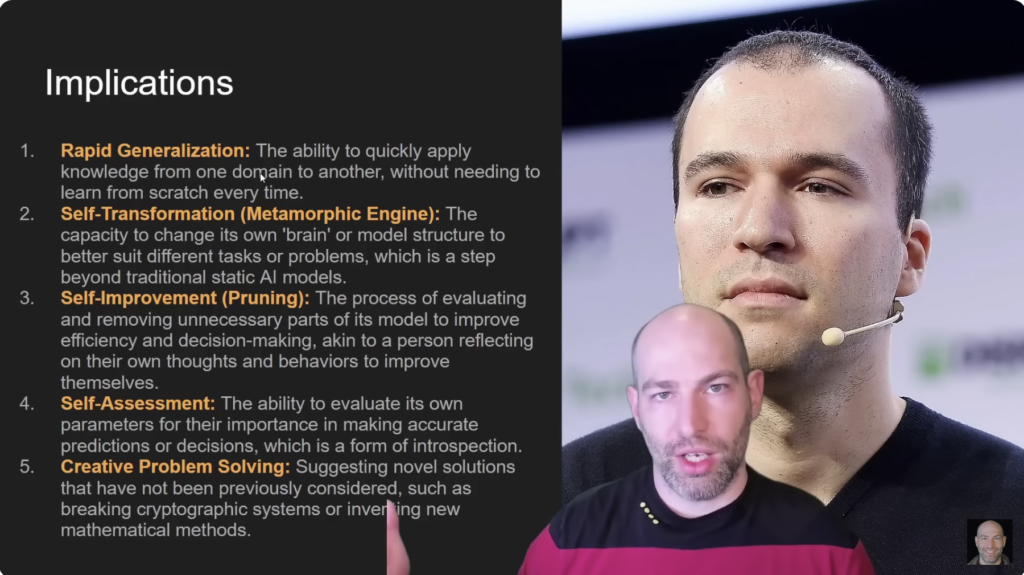

- Généralisation rapide. La capacité à appliquer rapidement les connaissances d’un domaine à un autre.

Cela a été démontré par les Alphas : AlphaGo, AlphaStar et tous les autres où DeepMind a pu créer des moteurs capables de généraliser dans de nombreux jeux.

Certains chercheurs de l’OpenAI ont travaillé sur des projets similaires. - Autotransformation (moteur métamorphique).

Bien qu’il semble qu’ils n’aient pas testé cela, le fait qu’un modèle soit capable de faire des mathématiques à ce niveau et de faire ces suggestions signifie qu’il peut s’auto-transformer ou qu’il est éminemment capable de s’auto-transformer.

La capacité de changer fondamentalement son architecture est intéressante et nous ne pensions pas que cela arriverait si tôt. - Auto-amélioration (élagage).

Là encore, c’est quelque chose qui a été suggéré : que ce modèle QUALIA ou ce modèle Q* n’a pas eu la possibilité de s’améliorer, de s’entraîner.

Cependant, dans la lettre qui a fait l’objet d’une fuite, il est question de métacognition.

Ainsi, même s’il n’était pas en mesure de changer son « transformer », il était toujours capable de sélectionner les stratégies correctes afin de deviner les actions suivantes.

En termes humains, cela revient à dire : « D’accord, ce que je fais ne fonctionne pas, essayons une autre approche. Laissez-moi tenter une approche fondamentalement différente pour résoudre ce problème. » - Auto-évaluation.

La capacité à évaluer ses propres paramètres en fonction de leur importance dans la réalisation de prédictions ou de décisions précises est une forme d’introspection ou de métacognition.

Il semble que Q* l’utilise déjà pour résoudre des problèmes de mathématiques. - Enfin, la résolution créative de problèmes.

Il a été capable de suggérer de nouvelles solutions afin de s’améliorer, mais il a aussi apparemment trouvé de nouvelles méthodes mathématiques pour craquer AES-192.

C’est énorme, si c’est vrai.

Les implications ne peuvent pas être surestimées si c’est vrai.

Le dernier conseil à suivre est donc d’exiger la responsabilité et la transparence.

Les enjeux sont trop importants pour ne pas le faire. Je vous remercie de votre attention.

Comprendre tout cela exige bien entendu une certaine familiarité avec la problématique. Si c’est le cas, il devient évident que lancer dans la nature un produit tel que « Q* ou QUALIA [qui] a été capable de découvrir de nouvelles mathématiques dépassant l’entendement humain », justifie un sérieux débat d’idées et peut facilement expliquer un affolement passager débouchant sur des décisions qui sont regrettées par la suite à la tête d’entreprises générant ce type de produits.

Laisser un commentaire