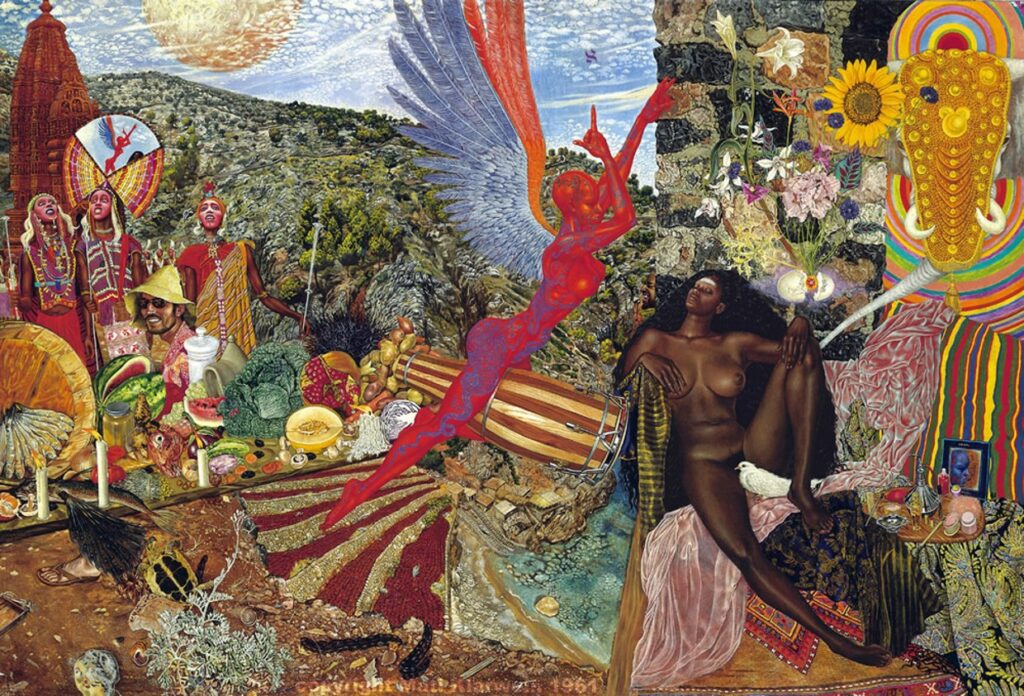

Illustration Stable Diffusion (+PJ)

Dans un tweet, il y a 3 jours, Sam Altman, le patron d’OpenAI, la compagnie derrière ChatGPT, appelait cela « superalignement » : comment faire pour que les objectifs d’une Intelligence Artificielle restent alignés sur ceux d’êtres humains qui seraient éventuellement (tousse ! tousse !) beaucoup moins intelligents qu’elle ?

a lot of compute dedicated to research focused on figuring out how to make superintelligence safe. please consider joining the team! https://t.co/ljyLjQ9W7d

— Sam Altman (@sama) July 5, 2023

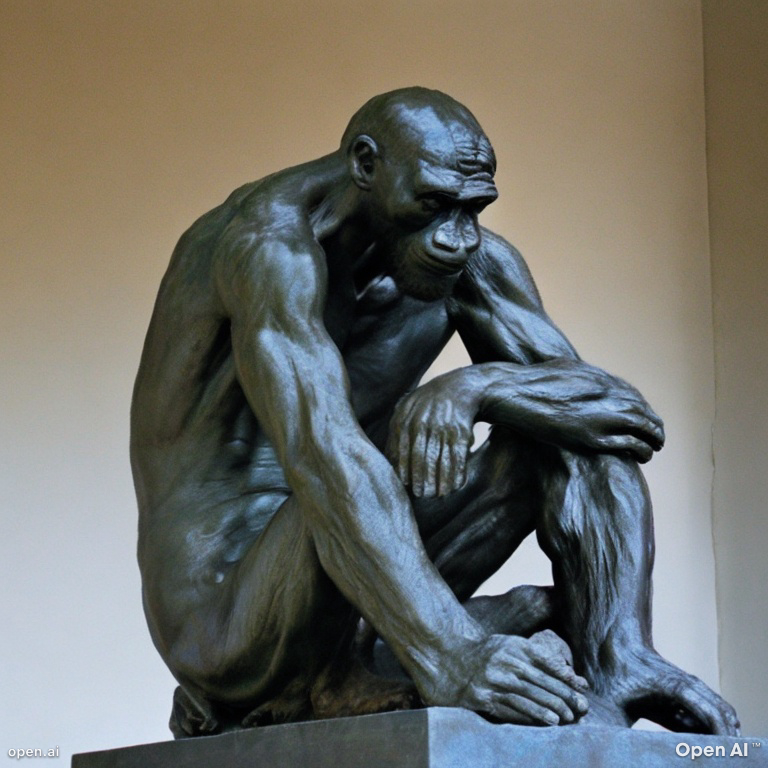

Formulé de cette manière, comme « superalignement » d’une IA super-intelligente, le problème reste très abstrait. D’où l’intérêt de le reformuler dans le cadre d’un casse-tête classique : celui de l’orang-outang qui aimerait anticiper le comportement de ses gardiens complotant de le changer de cage mais qui est trop bête pour interpréter leurs conciliabules.

Essayons donc de résoudre le casse-tête du « superalignement » sur un cas plus facile à se représenter : « Que pourrait faire un orang-outang pour que ses gardiens fassent ce que lui veut ? ».

Laisser un commentaire